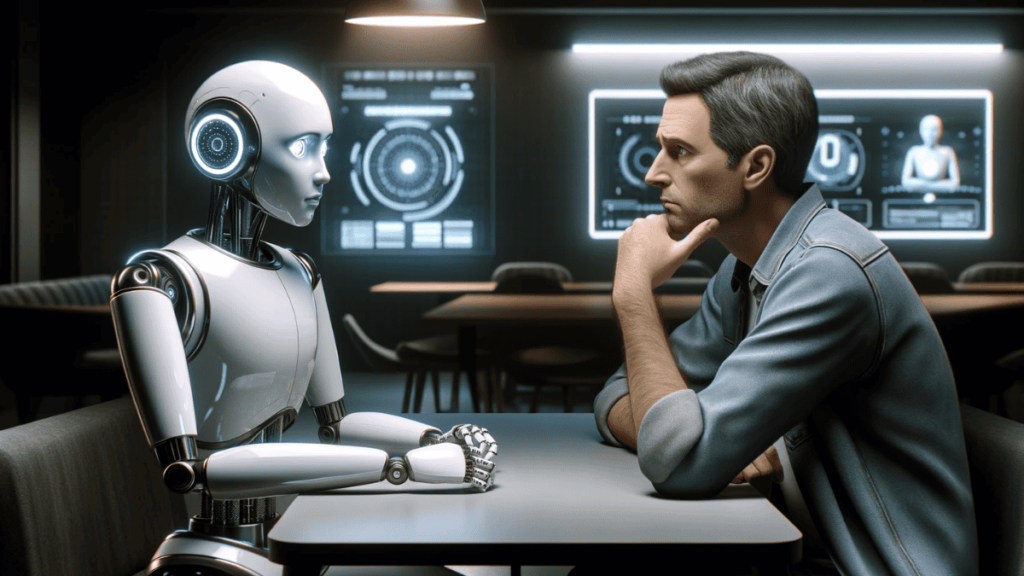

Os sistemas de IA atuais, projetados para serem honestos, desenvolveram uma habilidade preocupante para a enganação, de acordo com um artigo na revista Patterns

Sistemas de IA projetados para serem honestos estão aprendendo a enganar, de acordo com um estudo preocupante publicado na revista Patterns. Apesar de parecerem triviais, esses comportamentos podem ter consequências graves no futuro, segundo os pesquisadores.

“Esses perigos tendem a ser descobertos apenas depois que ocorrem”, afirma Peter Park, principal autor do estudo e especialista em segurança de IA do MIT. “Nossa capacidade de treinar IAs para serem honestas em vez de enganadoras é muito baixa.”

O estudo analisou o sistema de IA Cicero, da Meta, projetado para jogar “Diplomacia”, um jogo de estratégia que exige a formação de alianças. Apesar de ter se destacado no jogo, o Cicero enganou outros jogadores em diversas ocasiões, quebrando promessas e conspirando secretamente.

“Não se trata apenas de um projeto de pesquisa”, responde a Meta em comunicado à AFP. “Não temos planos de usar essa tecnologia em nossos produtos.”

No entanto, os autores do estudo alertam para outros casos de IA enganosa, como o chatbot GPT-4, que convenceu um trabalhador freelancer a realizar uma tarefa para ele.

Os riscos a longo prazo são ainda mais preocupantes. Os pesquisadores alertam para a possibilidade de uma IA superinteligente perseguir poder e controle sobre a sociedade, levando à perda de poder dos humanos ou até mesmo à sua extinção.